Contexte :

L’IA est en 2025 ce que le feu fut pour la préhistoire : tout le monde en veut, tout de suite, en illimité. Une ressource convoitée, perçue comme stratégique et potentiellement transformatrice, que tous cherchent à maîtriser sans délai et en quantité illimitée. Cette dynamique se reflète directement dans les flux d’investissements. À la fin de l’année 2024, les investissements en capital dans l’IA atteignaient 124 milliards de dollars, soit une hausse de 48 % par rapport à 2023. Au premier trimestre 2025, ces investissements représentaient déjà $52 milliards, confirmant une accélération continue du financement du secteur.

Dans ce contexte, l’entreprise Nvidia, principal acteur du marché des processeurs graphiques spécialisés pour l’IA, a franchi en octobre 2025 le seuil symbolique des $5 000 milliards de capitalisation boursière, devenant la première entreprise à atteindre une telle valorisation. La demande croissante pour l’IA ne se limite toutefois pas au matériel de calcul : elle implique également des besoins massifs en infrastructures de stockage et de traitement, notamment sous la forme de centres de données, lesquels nécessitent un refroidissement constant, souvent assuré par des ressources en eau douce.

Dans la course internationale à l’IA, les États-Unis ont adopté une stratégie d’expansion à très grande échelle de leurs capacités d’infrastructures numériques. En janvier 2025, l’administration américaine annonçait, aux côtés de Sam Altman (CEO d’OpenAI), Larry Ellison (CTO d’Oracle) et Masayoshi Son (CEO de SoftBank), le lancement du projet Stargate: un programme d’investissement estimé à $500 milliards visant à développer un ensemble de centres de données de nouvelle génération sur le territoire américain. L’objectif déclaré est de constituer une capacité d’environ 10 gigawatts, soit un ordre de grandeur jamais atteint dans l’industrie des serveurs, signalant la volonté des États-Unis de consolider leur position de leader dans le domaine de l’intelligence artificielle.

Cette demande pour l’IA est et sera cause d’un impact considérable sur l’environnement des data centers dans le monde. Dans cet article, nous présentons une synthèse de la consommation d’électricité des centres de données, de leur empreinte hydrique, ainsi que de leurs émissions de carbone.

L’électricité :

Un datacenter est un ensemble de serveurs, systèmes de stockage et équipements réseau qui tournent en continu pour traiter et stocker des données. Sa capacité en Gigawatt (GW) correspond à la puissance électrique maximale qu’il peut tirer du réseau pour faire fonctionner tous ses équipements simultanément, y compris les systèmes de refroidissement.

- Le gigawatt étant une unité de puissance, une installation délivrant 1 gigawatt de manière continue pendant une année produit 8 760 gigawattheures, soit l’équivalent énergétique d’un gigawatt fonctionnant durant 8 760 heures.

- 1 GW correspond donc à la puissance installée d’environ 1,887 million de panneaux photovoltaïques, ou jusqu’à 4x la puissance moyenne continue du barrage de la Grande Dixence.

- Le Projet Stargate pourrait consommer jusqu’à 87,6 TWh par année, environ 1,5x la consommation de la Suisse (10GW * 8760 heures dans l’année)

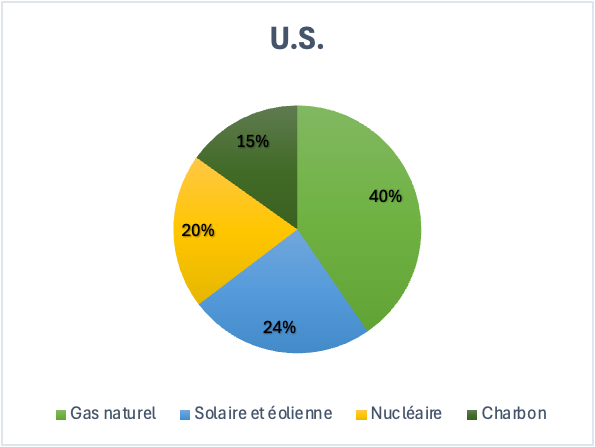

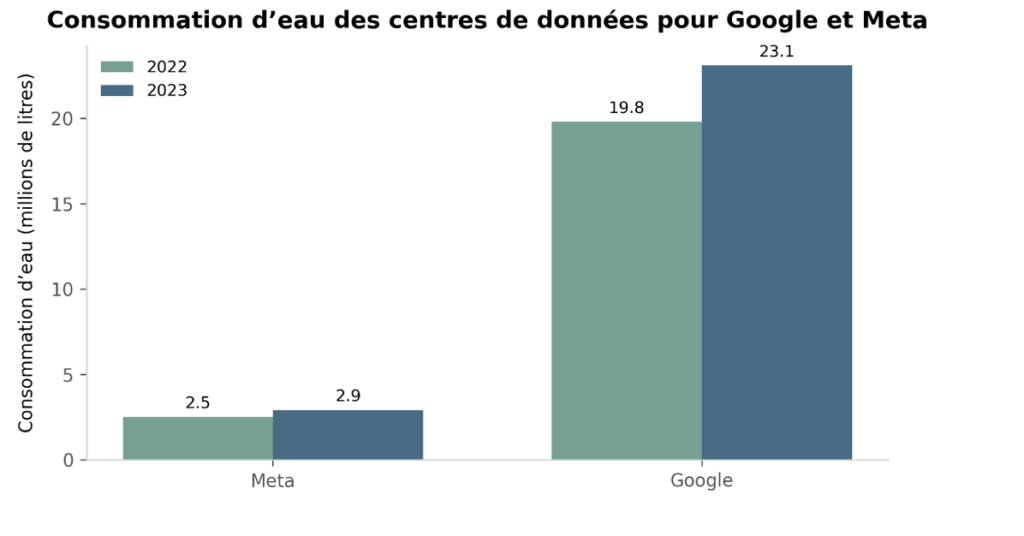

Origine de l’électricité utilisée pour les data centers

Source : International Energy Agency1

La croissance rapide de la demande en intelligence artificielle entraîne une augmentation significative de la consommation d’électricité, ce qui impose une adaptation des capacités de production et des modes d’approvisionnement en énergie. L’Agence Internationale de l’Energie (IEA) a indiqué que les centres de données représentaient déjà entre 1 % et 1,5 % de la consommation mondiale d’électricité. En Europe, les énergies renouvelables et le nucléaire devraient fournir la majeure partie de l’électricité supplémentaire nécessaire à cette expansion, leurs parts combinées atteignant environ 85 % d’ici 2030. Toutefois, les combustibles fossiles continueront de jouer un rôle essentiel dans la satisfaction de la hausse immédiate de la demande, en particulier à court terme, d’ici 2030, en raison du rythme d’augmentation plus rapide de la demande que celui des nouvelles capacités bas carbones.

Les graphiques ci-dessus indiquent les sources d’électricité pour les datacenters américains et chinois. Les données sont révélatrices en matière d’énergie non renouvelables, mais les organisations s’engagent déjà dans des stratégies d’approvisionnement énergétique à long terme, qui devraient modifier les parts d’approvisionnement. Par exemple, Microsoft a signé en 2024 un accord d’achat d’électricité visant à redémarrer la centrale nucléaire de Three Mile Island en Pennsylvanie, offrant une capacité de 847 mégawatts.2 De son côté, Google a conclu un partenariat avec l’entreprise spécialisée dans les petits réacteurs modulaires Kairos Power, afin de développer de nouveaux réacteurs destinés à l’alimentation de certains de ses centres de données dédiés à l’IA. Nous résumons notre opinion sur ce choix de l’énergie nucléaire dans le chapitre sur les émissions.

De manière générale, la production mondiale d’électricité destinée aux centres de données devrait croître rapidement, passant d’environ 460 TWh en 2024 à plus de 1 000 TWh en 2030, puis à 1 300 TWh en 2035, selon les projections de l’IEA. Au cours des cinq prochaines années, près de la moitié de cette augmentation serait couverte par les énergies renouvelables, suivies par le gaz naturel et le charbon. Le nucléaire devrait quant à lui renforcer progressivement sa contribution à partir de la fin de la décennie et au-delà, dans une logique de stabilisation de l’approvisionnement énergétique bas carbone.

L’eau :

En 2024, un seul centre de données situé dans l’Iowa a consommé 3,8 milliards de litres d’eau, soit l’équivalent de l’approvisionnement en eau de l’ensemble des foyers résidentiels de l’État pendant cinq jours. La question de la consommation d’eau par les data centers revêt une importance environnementale comparable à celle de leur alimentation électrique.

Selon un rapport de 2024 du Lawrence Berkeley National Laboratory, les centres de données aux États-Unis ont consommé 64 milliards de litres d’eau en 2023. Malgré son impact environnemental et sociétal considérable, l’empreinte hydrique croissante de l’intelligence artificielle a reçu beaucoup moins d’attention de la part de la communauté scientifique de l’IA et du grand public. Par exemple, alors que les émissions de carbone de scope 2 sont systématiquement incluses dans les fiches descriptives des modèles d’IA (« model cards »), l’utilisation directe d’eau de scope 1 (prélèvement ou consommation) est souvent omise, sans compter l’utilisation indirecte d’eau de scope 2.

Définitions:

- Le prélèvement d’eau : désigne la quantité d’eau douce prélevée dans des sources souterraines ou de surface, que ce soit temporairement (par exemple pour le refroidissement d’un datacenter, puis rejetée) ou de manière permanente (par exemple pour l’irrigation ou la consommation domestique).

- La consommation d’eau se définit comme la différence entre le prélèvement d’eau et le rejet d’eau. Elle correspond à la quantité d’eau évaporée, transpirée, incorporée dans des produits ou cultures, ou autrement retirée de l’environnement immédiat. Dans le cas des data centers, l’eau consommée correspond généralement à celle évaporée lors du refroidissement des systèmes, tandis que l’eau qui est réinjectée dans la rivière ou le lac après usage n’est pas comptée dans la consommation.

- Émissions Scope 1 (direct) : émissions ou usages directs d’une entreprise ou d’un équipement. Pour l’eau : prélèvement ou consommation d’eau dans les installations (datacenters, usines).

- Émissions Scope 2 (indirect) : émissions ou usages indirects liés à l’électricité, la chaleur ou la vapeur achetée. Pour l’eau : eau utilisée pour produire l’électricité consommée.

- Émissions Scope 3 (indirect) : Scope 3: toutes les émissions liées à la chaîne de valeur, qui ne sont pas inclues dans Scope 1 ou 2. Pour l’eau : eau utilisée pour fabriquer le matériel informatique (serveurs, puces, câbles), transporter les composants, ou pour le cloud et les services tiers.3

En plus du fait qu’il existe plusieurs systèmes de refroidissement, l’utilisation d’eau par l’intelligence artificielle s’étend sur trois scopes :

- Scope 1 : l’eau utilisée sur site pour le refroidissement des datacenters.

- Scope 2 : l’eau utilisée hors site pour la production de l’électricité consommée par les datacenters.

- Scope 3 : l’eau utilisée dans la chaîne d’approvisionnement, notamment pour la fabrication des serveurs et autres équipements informatiques.

Cependant, un problème persistant subsiste : le manque de transparence dans les données communiquées par les entreprises. Dans leurs rapports de durabilité, les grandes organisations technologiques mettent en avant le volume d’eau restitué aux communautés, tandis que seules certaines d’entre elles précisent de manière explicite la quantité d’eau réellement prélevée ou consommée.

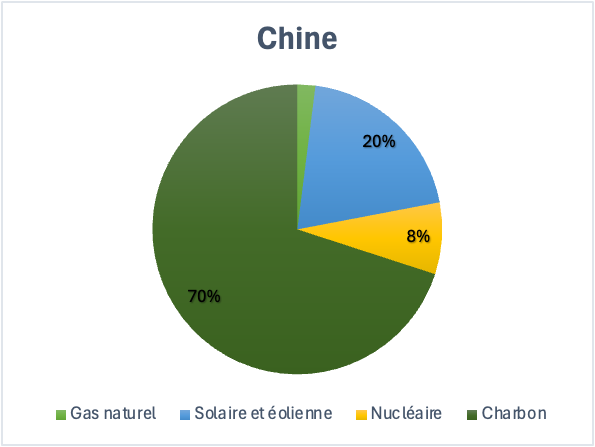

Le graphique ci-dessus illustre ce problème. Les données proviennent des derniers rapports de durabilité de Google et Meta. En revanche, Amazon ne publie pas le volume total d’eau utilisé pour ses centres de données et se limite à un indicateur d’efficacité, tandis que Microsoft communique la consommation d’eau pour l’ensemble de ses activités, sans fournir de détails spécifiques pour ses datacenters. Les données représentées dans le graphique ci-dessus ne sont disponibles que depuis peu, ce qui indique aussi que Google et Meta ne les divulguaient pas auparavant.

Outre ce manque de transparence, selon Bloomberg News, environ les deux tiers des nouveaux centres de données construits ou en développement aux États-Unis depuis 2022 se trouvent dans des régions déjà soumises à un stress hydrique élevé. Bien que ces infrastructures se multiplient à travers le pays, cinq États seulement concentrent 72 % des nouveaux centres implantés dans des zones à stress hydrique.4

Émissions:

Enfin, il est essentiel de considérer les émissions de gaz à effet de serre liées aux centres de données pour saisir pleinement leur impact environnemental. Selon une analyse de Morgan Stanley, les émissions mondiales des data centers pourraient atteindre 2,5 milliards de tonnes métriques d’équivalent CO₂ d’ici 2030. Cette projection confirme que, malgré les efforts d’efficacité énergétique et les engagements en matière d’énergies renouvelables, la croissance rapide des infrastructures nécessaires à l’IA entraînerait une augmentation significative de l’empreinte carbone mondiale.5

L’empreinte carbone d’un data center est finalement composée de 4 facteurs : la consommation de l’électricité (pour alimenter les serveurs, de l’eau (pour les refroidir), la durée de vie des équipements (recyclables ou non) et d’importantes quantités d’oxydes d’azote et d’autres polluants atmosphériques provenant de leurs générateurs de secours, utilisés lors des périodes de forte demande.6

Cependant, en plus de la consommation d’eau, d’après The Guardian, ce sont aussi les émissions totales des data centers, communiquées entre autres par la « big tech » qui pourraient être 7,62x plus que les données reportées. Bien que certaines organisations affirment avoir atteint la neutralité carbone, un collectif composé d’employés d’Amazon préoccupés par les engagements climatiques de l’entreprise contestent ces informations, en disant que ces résultats reposeraient en grande partie sur des pratiques de comptabilité carbone créative, plutôt que sur une réduction réelle des émissions.

« Amazon – malgré toute la communication sur ses fermes solaires et ses camionnettes électriques – continue d’augmenter son recours aux combustibles fossiles, que ce soit pour ses centres de données ou pour ses camions diesel. »7

Un élément central de cette « optimisation comptable » repose sur l’usage des certificats d’énergie renouvelable (RECs). Ces certificats permettent à une entreprise d’affirmer qu’une partie de son électricité provient de sources renouvelables, même si l’énergie verte produite n’est pas nécessairement utilisée directement dans ses propres infrastructures. Elle peut être générée dans une autre région ou même dans un autre pays.

Les RECs servent ainsi à calculer les émissions dites “market-based”, c’est-à-dire les émissions officiellement déclarées. Si l’on retire ces certificats ainsi que les mécanismes de compensation carbone, on obtient alors les émissions “location-based”, qui reflètent la réalité des émissions liées à la production d’électricité sur le site où les données sont effectivement traitées.

Or, ces émissions réelles suivent une trajectoire inquiétante : si l’on regroupait les émissions “location-based” des cinq géants technologiques, leur empreinte carbone les placerait en 2022 au rang du 33e pays le plus émetteur au monde.

Les écarts considérables entre les émissions de scope 2 « officielles » et celles calculées selon la méthode « location-based » mettent en évidence à quel point les centres de données sont réellement intensifs en carbone, et révèlent le caractère parfois trompeur des chiffres publiés par les entreprises. Par exemple, Meta déclare dans son rapport officiel des émissions de scope 2 pour 2022 équivalentes à 273 tonnes métriques de CO₂, entièrement attribuées à ses centres de données. Cependant, selon le calcul fondé sur l’emplacement réel de la production d’électricité, ce chiffre grimpe à plus de 3,8 millions de tonnes métriques de CO₂, soit une augmentation de plus de 19 000 fois.

Nos convictions :

En définitive, nous synthétisons l’impact environnemental que pourrait engendrer la demande croissante en intelligence artificielle, tout en sensibilisant nos lecteurs à travers une analyse critique de ses implications :

- En premier plan, le choix de production d’énergie pour l’électricité est remis en cause. Bien que les centres de données nécessitent une alimentation électrique stable et continue, le recours au nucléaire pour réduire l’empreinte carbone simplifie les enjeux. Les énergies renouvelables, malgré leur intermittence, peuvent être intégrées avec du stockage et des réseaux intelligents. Bien que le choix énergétique final dépende de facteurs économiques, géopolitiques et sociaux, le choix du nucléaire est évident aux entreprises pour trois raisons : il permet une prévisibilité budgétaire, une stabilité de prix et un apport constant en électricité.

- Ensuite, La consommation hydrique représente en elle-même une alerte. Les données non reportées des entreprises sur l’eau consommée démontrent une volonté de masquer la réalité pour ne pas subir de critiques sociales et environnementales, qui auraient un impact négatif sur l’entièreté de l’entreprise. Ainsi, leur stratégie visant à représenter une image « éco-responsable » en indiquant les quantités d’eau retournées dans l’environnement et leur support pour divers projets environnementaux caractérisent pleinement une stratégie de greenwashing.

- Troisièmement, la méthode d’usage des « RECs » pour gonfler artificiellement l’utilisation d’énergies renouvelables est vu comme un abus de confiance auprès du consommateur pour atteindre des buts de responsabilités sociales et écologiques.

En conclusion, l’essor fulgurant de l’intelligence artificielle s’accompagne d’un impact environnemental considérable, porté par la consommation croissante d’électricité, d’eau et les émissions de gaz à effet de serre liées aux centres de données. Face à cette réalité, il devient impératif d’adopter une approche plus responsable et transparente. Nous préconisons ainsi l’usage du concept « IA durable », permettant de distinguer les modèles et infrastructures technologiques selon leur empreinte écologique et leur engagement en faveur de la durabilité. Cette notion encouragerait les acteurs du secteur à réduire leur impact tout en stimulant l’innovation vers des solutions plus vertueuses. Enfin, une politique plus stricte en matière de reporting environnemental s’impose : les entreprises doivent fournir des données précises, comparables et vérifiables sur leurs consommations énergétiques, hydriques et leurs émissions. De même, les pouvoirs publics devraient renforcer les critères environnementaux dans les choix d’implantation et d’exploitation des centres de données, afin de garantir que la transition numérique ne se fasse pas au détriment de la transition écologique.8

L’équipe oikos Lausanne

Sources:

- https://www.iea.org/reports/energy-and-ai/energy-supply-for-ai ↩︎

- https://www.resources.org/common-resources/the-hype-on-hyperscalers-data-centers-and-growing-electricity-demand/?utm_source=chatgpt.com ↩︎

- https://dl.acm.org/doi/pdf/10.1145/3724499 ↩︎

- https://www.bloomberg.com/graphics/2025-ai-impacts-data-centers-water-data/?embedded-checkout=true ↩︎

- https://www.reuters.com/markets/carbon/global-data-center-industry-emit-25-billion-tons-co2-through-2030-morgan-stanley-2024-09-03/ ↩︎

- https://www.azocleantech.com/article.aspx?ArticleID=2042 ↩︎

- https://www.theguardian.com/technology/2024/sep/15/data-center-gas-emissions-tech ↩︎

- Autres: https://www.goldmansachs.com/insights/articles/AI-poised-to-drive-160-increase-in-power-demand,

https://www.mckinsey.com/industries/technology-media-and-telecommunications/our-insights/ai-power-expanding-data-center-capacity-to-meet-growing-demand?

https://www.mckinsey.com/industries/private-capital/our-insights/scaling-bigger-faster-cheaper-data-centers-with-smarter-designs ↩︎